Étude diachronique d’articles Wikipédia

- Porteurs du projet: Antonin Segault

- Projets de recherche, Projets pédagogiques

- 2018 - 2022

- Partenaires: Dicen

- Contact: Antonin Segault

- Éditorialisation, Méthodes quantitatives, Wikipédia

Ces travaux s’intéressent à l’évolution des articles sur l’encyclopédie Wikipédia et aux obstacles auxquels se heurte son étude. A travers différents cas, il s’agit d’identifier et/ou de construire des méthodes et des dispositifs susceptibles de favoriser la collecte, l’analyse et la visualisation des très nombreuses versions qui constituent l’historique d’un article donné. On pourra s’intéresser au contenu des articles, mais aussi aux liens qui les relient, aux références qu’ils mobilisent, ou encore aux échanges qui se déroulent dans les pages de discussion.

Concepts clés

Médiation des savoirs, Temporalité des médias, Commons-based peer production, Distant reading

Supports étudiés

Articles Wikipédia, historique des versions, pages de discussions, liens entre les articles, références mobilisées

Livrables

Communication dans un colloque scientifique, Article dans une revue scientifique, Programme informatique, Jeux de données

Méthodologie

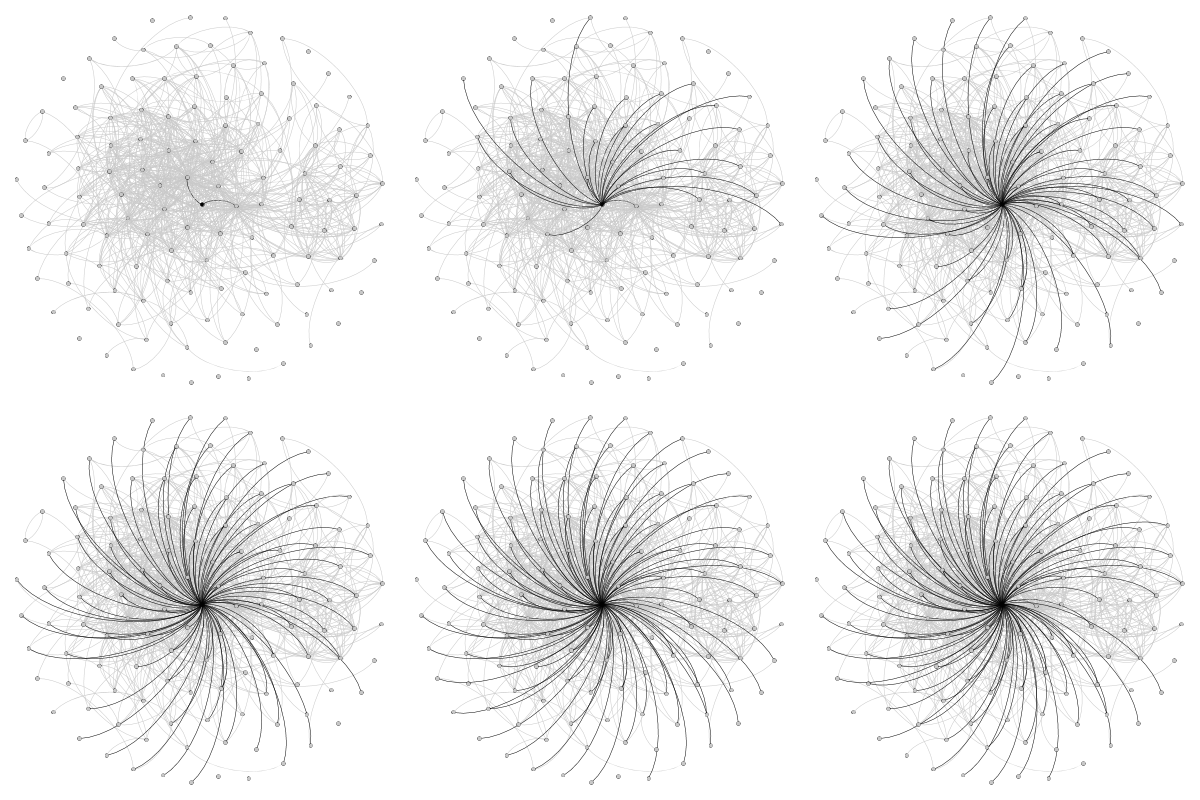

Si l’étude diachronique de Wikipédia n’est pas nouvelle, elle s’appuie le plus souvent sur des analyses qualitatives, nécessairement limitées à des nombres limités d’articles et de points temporels. Pour dépasser ces limitations, ce projet s’inscrit dans la lignée des travaux relatifs à la lecture distante des historiques de version. Les premières études ont conduit à la conception et au développement de Historic Graphs (https://framagit.org/retrodev/historic-graphs), un outil s’appuyant sur les API de MediaWiki pour construire des graphes dynamique montrant l’évolution liens entre articles au cours du temps. En raison de la densité considérable (et croissante) du réseau de liens de l’encyclopédie, notamment autour d’articles aux thématiques géospatiales (années, noms de pays, etc.), l’analyse de tels graphes s’avère néanmoins délicate. D’autres développements sont envisagés, pour faciliter l’analyse de l’évolution conjointe d’un nombre limités d’articles. Des approches plus qualitatives ont également été explorées, à travers l’usage des références ou encore la comparaison avec d’autres temporalités médiatiques (presse, littérature scientifique).

Résultats attendus

Ce projet vise à déterminer les conditions dans lesquelles cette Wikipédia peut constituer une source pertinente pour étudier l’évolution de certains concepts et de leurs représentations dans l’espace public au cours d’une période données. Ces travaux doivent également clarifier la place occupée par l’encyclopédie au sein de l’écosystème médiatique qui, tour à tour, l’alimente et s’en alimente. Ils vont pour cela entrer en résonance avec beaucoup des recherches actuelles sur la recomposition de cet écosystème, des acteurs qui le composent et des principes qui fondent sa légitimité.

Dates clés

• 2018 : début du projet et développement des premières versions d’Historic Graphs

• 2019 : présentation de l’outil et d’un premier cas d’étude (attentats du 13 novembre 2015 à Paris) lors de la conférence H2PTM, discussions sur les limites des graphes : Segault, A. (2019). Historic Graphs : Cartographie dynamique des liens sur Wikipédia. H2PTM 2019, De l’hypertexte aux humanités numériques.

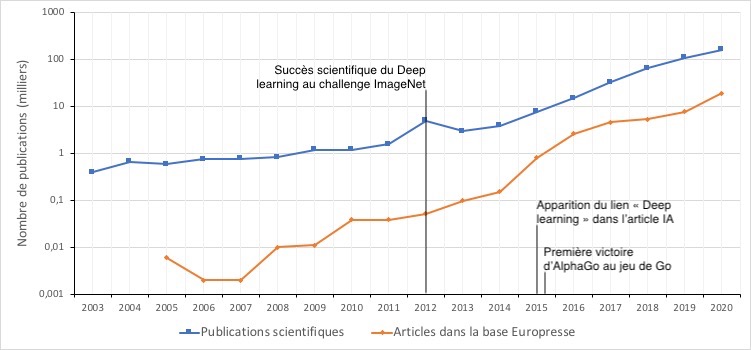

• 2021 : présentation d’un cas d’étude (incluant la dimension qualitative et la comparaison des temporalités) sur la représentation de l’intelligence artificielle lors de la conférence H2PTM : Bouchereau, A., & Segault, A. (2021). Évolution des représentations de l’intelligence artificielle : De quelle(s) IA Wikipédia est-elle l’encyclopédie. H2PTM 2021, Information : Enjeux et nouveaux défis.

• Accès aux jeux de données : https://framagit.org/retrodev/historic-graphs/-/tree/master/examples/h2pt https://framagit.org/bouchereaua/ia-wikipedia-h2ptm21

Autre membre impliqué

Aymeric Bouchereau (UPEC / Lab’Urba)